音と映像を駆使するマルチメディアコンテンツ制作では,音声情報に関する知識が欠かせない.マルチメディア検定でも,アナログ信号である音声をディジタル化(AD変換)するための基本方式として,PCMやDOTなどの基礎知識が試される.また,実際にコンピュータが音声を鳴らす(再生する)ための装置(音源)として,PCM音源,FM音源,そしてMlDI音源も必須の知識である.

PCMは,アナログ音声信号をディジタル信号に変換し,搬送する変調方法で,1937年にフランスのり一プスによって発明された.この発明は1948年にシャノンが「情報理論』を発表したことによって,一躍脚光を浴びるようになった.しかし,当時の実験用試作ではPCMは回路技術の複雑さに加えコストが高いことから,その後の研究の進展はなかった.本格的にPCMが注目されるのは,コンピュータがトランジスタからICを用いたものへ発展を遂げていく過程の中であった.マルチメディア時代に入って,画像情報や音声情報に対する重要性の認識が高まり,PCMが音声データの搬送方法として,より一層注目されるようになった.CDやDATはこのPCM方式を採用している.

PCMの基本系統は,「標本化→量子化→符号化」である.標本化では,連続なアナログ信号から一定間隔ごとにとびとびの信号を抽出する.標本抽出の意味からこの作業を標本化と呼ぶ.量子化は,とびとびに抽出された信号の振幅の大きさを数値化することをいう.符号化は,量子化された振幅をコンピュータが理解できる2進数で表す作業をいう。

図1 標本化,量子化,符号化

PCMにおける標本化では,ある時点ごとに振幅を抽出するが,これは連続信号を図2に示すような階段状の図形に近似していることになる.したがって、1秒間に行う標本化の数、すなわち標本化周波数(サンプルレート)を増やすことによって近似精度が上がる.また,量子化では,想定している最大振幅をある決められたステップ数に分割し,アナログ信号の振幅を,そのステップ幅を単位とした整数値で近似している.例えば図3では8ステップ(3ビット)に分割したスケールを用いているが,アナログ信号の振幅が4と5の間の値であるにもかかわらず,量子化の値は4となる.そこで,量子化の精度を上げるためには,全体を分割するステップ数(ビットレート)を増やす必要がある.

以上からわかるように,サンプルレートとビットレートを無限に上げない限り,PCMでディジタル化された音声は元の音声より情報量が少ない.

図2 サンプリングによる近似

図3量子化近似

PCMではサンプルレートやビットレートが大きい方が音質が良い.しかし実際は,コンピュータのメモリや記録媒体の容量を考慮すると十分なレートを設定することができない場合が多い。そこでPCMに工夫を加え,音声情報を圧縮するためにADPCM(適応PCM)方式が考えられた一般の音声波形を標本化するとき,隣どうしのサンプル信号は互いに近い値をとることが予想される。そこでADPCMでは,隣接するサンプル信号の差分を量子化する.これによって,全体の振幅が大きい波形でも小さいビットレートで十分に量子化できる.ADPCMはISDN,衛星通信そして長距離通信で利用されている。

この方式は離散コサイン変換,またはフーリエ変換と呼ばれているものである.通常私たちの周りに存在する任意の波形は,いくつかのコサインカーブとサインカーブにある重みをかけて足し合わせたもので表現できることがわかっている.このとき,コサインカーブの周期と足し合わせるときの重みを音声情報として量子化する方式がDCTである.DCTはTV電話,移動電話,自動車電話など広く採用されている.

図4 DCT方式

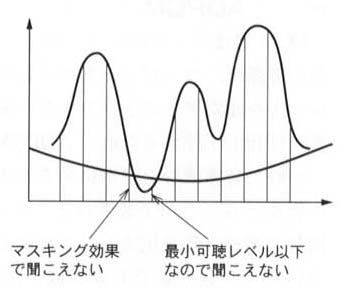

ATRACとPASCでは,ほぼ同様の手順で音声情報を圧縮する.まず,元の音声信号をあらかじめいくつかの周波数帯に分割し,次に分割された音声信号をDCTで符号化する.また,最小可聴レベル(後述)以下の周波数をカットしたり,マスキング効果(後述)と呼ばれる心理聴覚特性も利用される.ATRACはMDに,PASCはDCCに採用されている.

人間が音声を聞く場合,ある程度大きな音でないと聞こえない周波数領域がある.これを最小可聴レベルと呼ぶ.また,ある強い音が存在すると,その周辺の弱い音は聞こえないという心理聴覚特性をマスキング効果と呼ぶ.

図5 可聴レベルとマスキング効果

PCMデータを再生する音源(音を鳴らすための装置).PCMは,先に述べたように本物の楽器から出た音を「標本化→量子化→符号化」の手順で録音することからサンプリング方式とも呼ばれる.

FM音源は,先に解説したDCTの逆の作業を行って音声を鳴らす音源と覚えてもよい.ただし,DCTではサインカーブを足し合わせるのに対して,FM音源は,音色の異なる複数の音源データを組み合わせてさまざまな新しい音色を作り出す.FM音源をはじめて採用したシンセサイザとして,ヤマハのDX-7が有名である.

MIDIは,2・3節で詳しく解説するが,電子楽器とコンピュータの接続と制御方式を定めたプロトコル規格である.MIDIデータの特徴は,PCMなどに比べて,少ない情報で音楽を表現するのに必要なパラメータを伝送できる点である.

質の良い音声がコンピュータで再生可能になるにつれて,マルチメディアコンテンツの作成に,音響・音楽の知識が必要とされる場面が増加してきた.検定でも音響に関わる知識が試される問題が多く出題されるそこで,一般の音響音楽の知識の中で,コンピュータ上で音声を扱うときに必要となる項目は理解しておく必要がある.

すべての色は赤,青,黄の3原色を混ぜ合わせることによって作られることはよく知られている.音も,音程,音色,音量の三つの基本要素を組み合わせることによってすべての音色を作り出すことができる.

◆音程

音程は二つの音の周波数の隔たりを表す言葉で,「度」という単位を用いて表す.たとえば,譜面に示される,ドの音とレの音の音程は1度である.また,ある高さのうとその一つ下のうの音程は「8度」である(8度の音程を特別に,オクターブと呼ぶ).音楽の世界では基準となるラ音の周波数を440Hz(442Hzやそのほかの場合もある)としている.このとき基準のうの1オクターブ上の音程は880Hzである.このようにオクターブの音程では周波数の比が2である.

ピアノの鍵盤にはオクターブの間に12個のキーがある.各キーには周波数の比が一定になるように1オクターブを12分割した音程が割り当てられている.これを12平均率音階と呼ぶ.

■音量

音量には以下に解説する音圧とphoneがある.また,関連事項としてダイナミックレンジがある.

(i) 音圧音量は,音波の振幅の大きさ(図2)に相当する.しかし,同じパワーをもつ音波であっても,音波が伝わる媒体によって振幅の大きさは異なる.そこで,実用的には,音のパワーを表す「音圧」を用いて音量を表す.音圧は,音を伝える媒質中の気圧(圧力)が音のないときの気圧より高くなった変化分である.音圧は指数的に値を変化させるので,通常は基準音圧との比の対数をとった音圧レベルを使う.うまり,音圧レベルの単位はdBである.

(ii) phone音圧レベルは物理的な音波の振幅であるから,人間の実際の感覚とは異なる場合が多い.つまり,音色やそのほかの要素によって,同じ音圧レベルの音声であっても音量が異なって聞こえる場合がある.このような,人間の感覚を基準にした音量の単位がphoneである,ある音のphone数は,その音と同じ音量に聞こえる周波数1kHzの単一正弦波(サインカーブ)の音圧レベルである.たとえば,20phoneの音量は,20dBの周波数1kHz単一正弦波と同じ音量に聞こえる.

(iii) ダイナミックレンジ最大音圧と最小音圧の差をダイナミックレンジという.単位はdBである.音楽用のCDに記録可能なダイナミックレンジは96dBで,人間の耳で聞くことのできるダイナミックレンジは120dBである.マイクロフォンなどでダイナミックレンジを超えた音声信号を出力するとディストーション(歪み)が生じ,人間の耳にダイナミックレンジを超えた音声信号を入力すると耳が痛くなったり鼓膜が破れたりする.

図1 音程と音量(模式図)

●音色

音色は,音声のもっている属性から,高さ(絶対的な音程)と音量を取り除いた部分を指す.人間の声の違い,楽器の音色の違いはこの音色によって決まる,音色を決定する要素にはエンベロープと倍音がある.以下にそれぞれを解説する.

(i) エンベロープ 音の立ち上がりから減衰して聞こえなくなるまでの音量の変化のパターンをエンベロープと呼ぶ.私たちの身の周りに存在する音にはそれぞれ固有のエンベロープがある.

図2ピアノのエンベロープとフルートのエンベロープ

(ii) 倍音 音声信号には,一つの周波数だけでなく,複数の周波数の成分が含まれている.その中で,最も低い周波数の成分を基音と呼び,基音より高い周波数の成分を倍音と呼ぶ.エンベロープと同様に,私たちの身の周りの音はそれぞれ固有の倍音構成をもっている.

図3 基音と倍音

図4 倍音の多い波形

同じ音源から発せられた音声であっても,それが人の耳に届くまでには,壁にぶつかって反射したり,ある倍音だけが増幅されたり,吸収されたりして,元の音とは異なる音色で人の耳に届く.このように,実際に音声が人の耳に届くまでの道筋を含む空間を音場という.音場の典型例はホールである.そして,音場に響く音声を再生することを音場再生という.

音場再生の技術として,以下に二つの例を紹介する.

◆ホール音場再生

音波がホールの壁にぶつかったときに増幅,または吸収される倍音および残響として残る倍音(反射音)をシミュレートする.これは,実際にホールに響く音を再現するための技術である.

●サラウンド音場再生

人間の耳は二つあり,目と同様に,両耳の聞こえ方の違いから音の奥行きや広がりを感じとることができる.このように,音の奥行きや広がりを再現する技術をサラウンド音場再生と呼ぶ.

サラウンド音場再生を実現するために,ダミーヘッド(二つのマイクが装着された,人間の頭の形をした人工頭と呼ばれる録音装置)を用いて録音された音声を再生する技術もある.

エフェクタ

音場の再生には,反射音や残響音をシミュレートする技術のほかに,音声信号をエフェクタと呼ばれる回路に通すことによって音声を加工する技術がある.以下では代表的なエフェクタを紹介する.

◆イコライザ

入力音波に含まれる特定の倍音(周波数帯)を増幅または吸収するエフェクタ.音色を変化させるときに用いられる.

◆ピッチコントローラ

ハーモナイザ,ピッチチェンジャとも呼ばれるエフェクタで,音色を変えずに音程を変更することができる.

◆コンプレッサ,エキスパンダ,リミッタ

コンプレッサは音量を小さく,エキスパンダは音量を大きくするエフェクタ.リミッタは一定レベルを超えた音量をカットする.

◆フェーダ

音の立上がりや立下がりをスムーズにするエフェクタ.フェイドイン,フェイドアウトの効果を与える.

◆ミキサ

複数の音声信号を合成するためのエフェクタ.

◆ディレイ

指定した時間だけ遅らせた音声信号と,元の音声信号を合成するエフェクタ.余韻を残す効果がある.

◆エコーマシン

エコー効果を与えるエフェクタ.ディレイを繰り返しかけることによって,残響効果を与えるエフェクタ.

◆リバーブレータ

延長時間の異なるディレイを複数加えることによって,広い空間での残響をシミュレートするためのエフェクタ.

コンピュータを使った音楽全体を総称してコンピュータミュージックと呼ぶが,特にパソコンを利用して簡単に机の上で作曲・編曲をすることをDTM(デスクトップミュージック)という.口TMに欠かせなし、MIDIに関する事項は検定に出題される可能性が高い.

MIDIは1982年,ドイツのOberheim社,日本のROLAND社,米国のSequential Circuit社らによって提唱された音楽関連の統一規格である.「どの音程をどのような音色でどのくらいの時間鳴らすか」という情報を8ビットで構成データを用いてやり取りするためのインタフェース規格で,ステータスとデータの2種類に分けられている.

以下では,これら二つのメッセージの働きとその見分け方を解説する.また,実際にMIDIデータを送受信するときに必要となる知識としてMIDIチャネル,MIDIインタフェース,MIDI端子,MIDIシーケンサそしてシーケンスソフトについて解説する.

図1MIDIデータ

●ステータスメッセージ

このメッセージは,「鍵盤が押された」または「ピッチホイールが操作された」など,今起こった出来事(イベント)が何であるかをMIDI音源に伝えるためのメッセージである.

●データメッセージ

このメッセージは,ステータスメッセージの後に送られるメッセージで,イベントの詳細を決定するパラメータを表すデータである.たとえば,ステータスメッセージが「鍵盤が押された」(ノートオンメッセージ)であったとき,それに続くデータメッセージは「どの鍵盤が押されたのか」と「どのくらいのベロシティで押されたのか」を示す.

◆ステータスとデータの見分け方

送られてきたメッセージがステータスなのかデータなのかは,コードナンバーの違いによって識別される.

8ビット情報では,0から255までの数値を表すことができるが,前半の0から127まではデータメッセージ,後半の128から255まではステータスメッセージと決められている.

◆MIDIチャネル

MIDIは複数の楽器を同時に制御して演奏を行うために16個のチャネルが用意されている.つまり,16台の異なるMIDI楽器を同時に使って演奏することができる.チャネル情報はMIDIデータのステータスメッセージに含まれている.

◆MIDIインタフェース

MIDIデータは単なる8ビットのディジタル信号であるから,MIDIデータを出力しただけでは音を鳴らすことはできない.そこで,実際にMIDIを用いて演奏するには,MIDIデータを音源または楽器が読み取れる信号に変換する必要がある.このような機能をもったインタフェースをMIDIインタフェースという.

◆MID1端子

MIDIインタフェースを備えた音源,または楽器間でのMIDIデータのやり取りは,5ピンのDINコネクタつきのケーブル(MIDIケーブル)を通じて行われるが,情報の伝達方向が一方向に限られているのが特徴である.したがってほとんどのMIDI機材は,MIDI

IN,MIDI OUT,MIDI THRUの三つの端子(MIDI端子)を備えている.

MIDI INは,外部MIDI機材から本機材へのMIDIデータの入口で,MIDI OUT,またはMIDI THRUと接続される.MIDI OUTは,本機材での演奏内容を伝えるMIDIデータの出口で,MIDI

INと接続される.MIDI THRUは,外部MIDI機材から本機材へ入力(MIDI INに入力)されたMIDIデータを,何も手を加えずにそのままもう一つの外部MIDI機器へMIDIデータを出力するもので,MIDI

INと接続される(本機材での演奏内容は出力されない).

図2MIDl端子

◆MIDlシーケンサ

MIDIデータをシンセサイザやサンプラーなどのMIDI音源または楽器へ送信し制御する自動演奏装置がシーケンサである.ハードウェアとしてのシーケンサもあるが,パソコンを用いたDTMではシーケンスソフトが用いられることが多い.

◆シーケンスソフト

コンピュータにMIDIデータを記録するためのインタフェースをもったソフトウェアをシーケンスソフトと呼ぶ.シーケンスソフトのインタフェースの代表的なものには,数値による表現,バーによる表現そして音符による表現がある.

(i) 数値による表現 数値による表現はパソコンのテンキーだけを使って入力できるため,慣れれば入力速度は速いが,音楽的な意味合いや音程の動きを読み取るのが難しい.

(ii) バーによる表現 バーによる表現の優れた点は,実際の演奏に出現する微妙な音長を視覚的に表すことができることである(実際に演奏家によって演奏される場合,それぞれ音の長さは音符で示された音長と微妙に異なる).

(iii) 音符による表現 音符による表現は,音楽の基礎知識をもったユーザに受け入れられやすい表現であるが,実際の演奏に近づけるために,別にテンポやベロシティを変更する必要がある.

実際にMIDIデータがどのように流れるかを,パソコンをシーケンサとしてMIDI音源に接続した場合について解説する.

◆パソコンからのMIDlデータ出力

パソコンで編集されたMIDIデータはシリアルポート(Macintoshの場合モデム,またはプリンタポート,DOS/V機の場合RS-232C端子,または専用のMIDIポート)から出力され,MIDIインタフェースを備えた音源に送られる.

■MIDlINからの入力

MIDI IN端子を通じてMIDIデータを受け取った音源は,ステータスメッセージに含まれるチャネル情報をその音源が設定されているチャネル情報と照らし合わせる.そして両者が一致したときだけ,それに続くデータメッセージの内容にしたがって音を鳴らす.

●MDI THRUからの出力

MIDI INから受け取られたMIDIデータは,そのままMIDI THRUから出力される.

●MID1OUTからの出力

MID1OUTからはその楽器で演奏された内容がデータとして出力される.MIDITHRUからは演奏内容は出力されないことに注意.

図3MIDIデータの流れ

現在では,簡単にパソコンにMIDIシーケンサとMIDI音源を内蔵することができる.しかし,パソコンが普及する以前は,MID1音源と言えばシンセサイザとサンプラーが代表的なものであった.ここでは,この二つの音源について解説する.

◆シンセサイザ 送られてきたMIDIデータに基づいて,実際に音を発する楽器がMIDI音源であるが,その代表的なものはシンセサイザである.シンセサイザは電子回路で音を合成し,さまざまな音を発生させる装置である.疑似的な楽器音や各種の動物の音声を合成して発生させるシンセサイザもある.楽器音を発生させるものには,アナログ式とディジタル式のものがあり,ディジタル式のものは,FM音源やPCM音源を使用しているものが多い.

■サンプラー 複数の音色の異なる音声信号を重ね合わせて目的の音色を作りだすシンセサイザと異なり,サンプラーはディジタル録音された生の音声をそのまま再生する方法で音を出す.サンプラーは録音できる音ならば動物の鳴き声や空缶を叩く音でも好きな音程で鳴らすことができる.もちろん,MIDIインタフェースを備えたサンプラーもある.